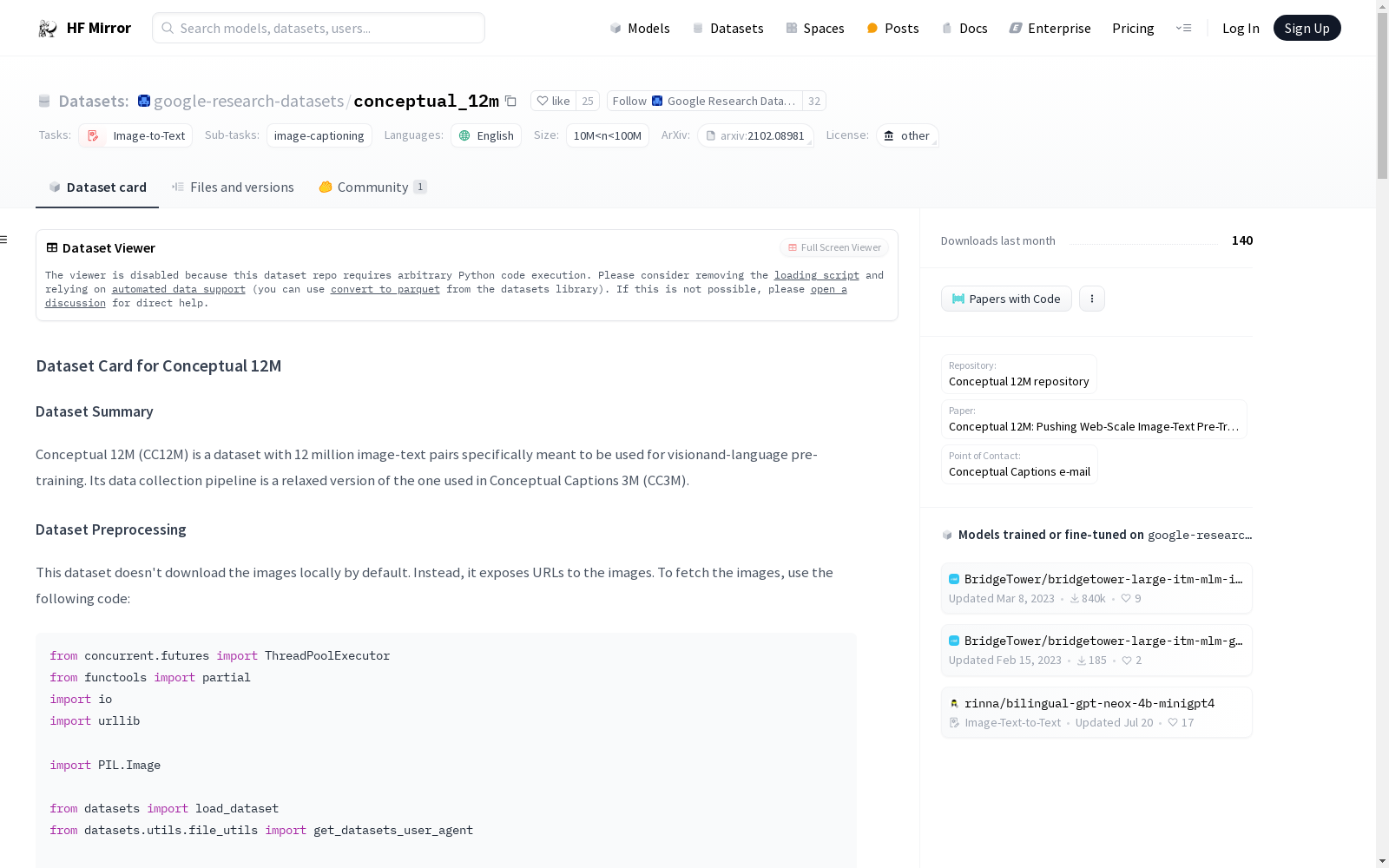

google-research-datasets/conceptual_12m|图像描述数据集|视觉语言预训练数据集

收藏数据集概述

数据集摘要

Conceptual 12M (CC12M) 是一个包含1200万对图像-文本对的数据集,专门用于视觉和语言预训练。其数据收集流程是Conceptual Captions 3M (CC3M)的一个宽松版本。

数据集结构

数据实例

每个实例代表一个带有描述的图像:

json { "image_url": "http://lh6.ggpht.com/-IvRtNLNcG8o/TpFyrudaT6I/AAAAAAAAM6o/_11MuAAKalQ/IMG_3422.JPG?imgmax=800", "caption": "a very typical bus station" }

数据字段

image_url: 用于下载图像的静态URL。caption: 图像的文本描述。

数据分割

数据集仅包含训练数据,共有12423374条记录。

数据集创建

数据收集和规范化

从论文中提取的数据收集和规范化步骤包括:

- 图像过滤:最大尺寸比设置为2.5,保留大于400像素的JPEG图像,排除触发色情检测器的图像。

- 文本过滤:允许3到256个单词的alt-text,排除没有名词或没有限定词的候选,允许没有介词的候选,最大单词重复比设置为0.2。

- 文本处理:不进行超名词化或数字替换,仅对人物名称进行替换以保护隐私。

注释过程

注释与图像一起通过自动管道提取。

个人和敏感信息

对人物名称进行替换以保护隐私,使用Google Cloud Natural Language APIs检测并替换为特殊标记<PERSON>。

数据集使用注意事项

社会影响

[更多信息待补充]

偏见讨论

[更多信息待补充]

其他已知限制

[更多信息待补充]

附加信息

数据集策展人

Soravit Changpinyo, Piyush Sharma, Nan Ding 和 Radu Soricut。

许可信息

数据集可自由用于任何目的,但建议对Google LLC作为数据源给予认可。数据集按“原样”提供,不附带任何明示或暗示的保证。Google对使用该数据集造成的任何直接或间接损害不承担任何责任。

引用信息

bibtex @inproceedings{changpinyo2021cc12m, title = {{Conceptual 12M}: Pushing Web-Scale Image-Text Pre-Training To Recognize Long-Tail Visual Concepts}, author = {Changpinyo, Soravit and Sharma, Piyush and Ding, Nan and Soricut, Radu}, booktitle = {CVPR}, year = {2021}, }