MT-PREF|机器翻译数据集|偏好分析数据集

收藏arXiv2024-10-10 更新2024-10-12 收录

下载链接:

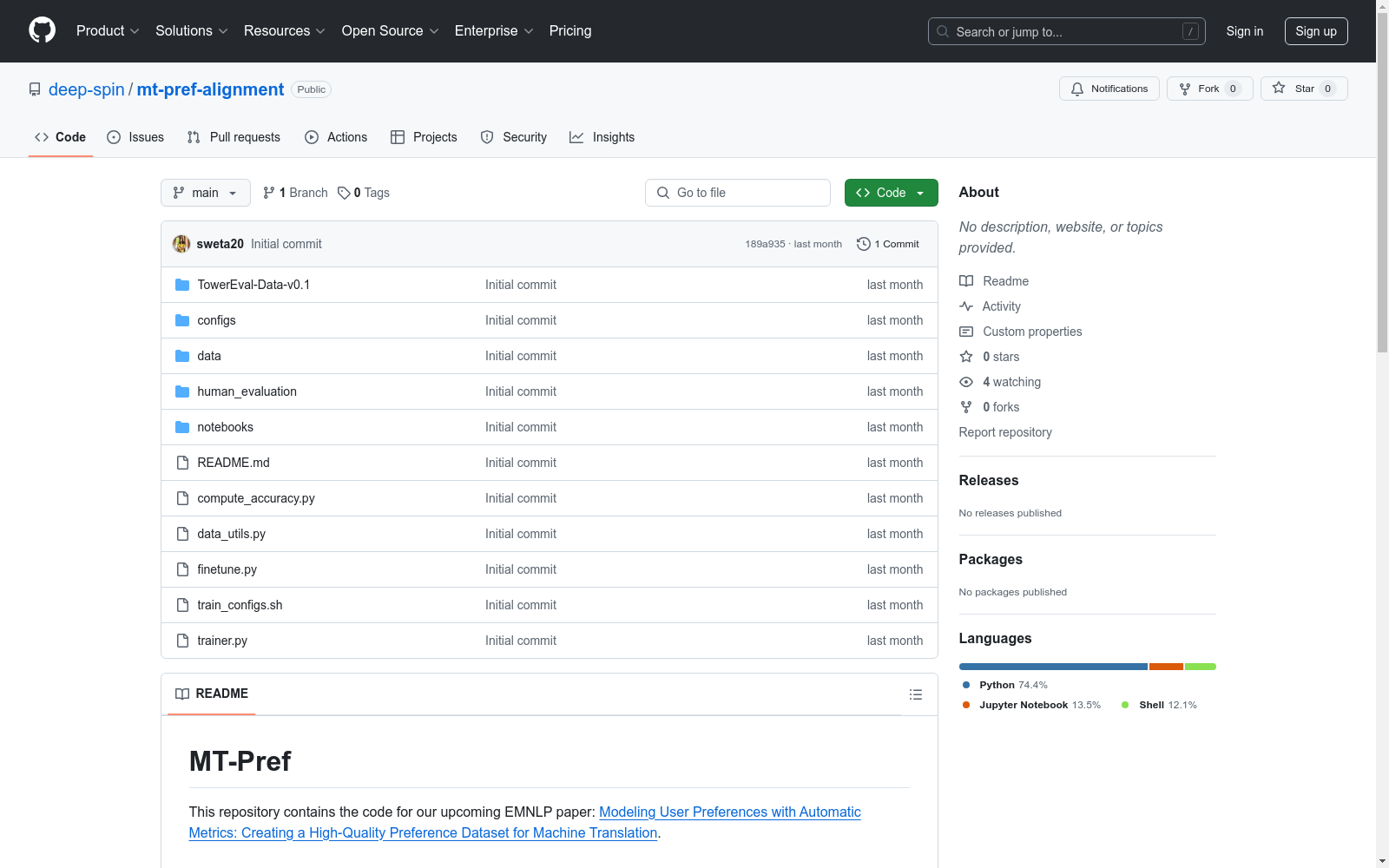

https://github.com/deep-spin/mt-pref-alignment

下载链接

链接失效反馈资源简介:

MT-PREF数据集由电信研究所和高等技术学院等机构创建,旨在通过自动评估指标来模拟用户对机器翻译的偏好。数据集包含18,000个实例,覆盖18种语言方向,文本来源广泛,主要从2022年后的多个领域中提取。数据集的创建过程包括收集专业语言学家的质量评估,并使用XCOMET-XL+XXL指标进行偏好分析。MT-PREF数据集主要应用于机器翻译领域,旨在通过高质量的偏好数据集来提升翻译模型的准确性和安全性。

提供机构:

电信研究所, 高等技术学院, 里斯本大学, Unbabel, ELLIS里斯本单位, 卡内基梅隆大学, MICS, 中央理工-高等电力学院, 巴黎-萨克雷大学

创建时间:

2024-10-10

原始信息汇总

MT-Pref 数据集概述

数据集简介

MT-Pref 数据集是一个用于机器翻译(MT)的偏好数据集,旨在通过自动评估指标来模拟用户偏好。该数据集包含 18,000 个实例,涵盖 18 种语言方向,文本来源包括多个领域,时间范围为 2022 年之后。

数据集内容

- 数据来源: 数据集包含多个高质量机器翻译系统生成的翻译结果,并由专业语言学家进行句子级别的质量评估。

- 自动评估指标: 数据集提供了多种自动评估指标的评分,用于分析这些指标在恢复人类偏好方面的能力。

- 附加数据: 数据集还包括在 WMT23 和 FLORES 基准测试上训练模型的所有评估结果,以确保可重复性。

数据集链接

MT-Pref 数据集可通过以下链接获取:sardinelab/MT-pref

数据集用途

该数据集主要用于训练和评估机器翻译模型,特别是那些旨在更好地处理语言细微差别和上下文特定变化的模型。通过使用 MT-Pref 数据集进行训练,模型在 WMT23 和 FLORES 基准测试上的翻译质量显著提升。

AI搜集汇总

数据集介绍

构建方式

MT-PREF数据集的构建结合了人工评估与自动指标的优势。首先,通过专业语言学家对多个高质量机器翻译系统生成的翻译进行句子级别的质量评估,收集了大量的人类偏好数据。随后,利用当前的自动质量评估(QE)指标来分析这些偏好数据,以确定这些指标在多大程度上能够准确反映人类的偏好。基于这一分析,MT-PREF数据集被精心构建,包含了18种语言方向的18,000个实例,这些实例的文本来源广泛,且均在2022年后发布。通过这种方式,MT-PREF数据集不仅确保了数据的多样性和时效性,还通过自动指标的引入,提高了数据集的规模和质量。

特点

MT-PREF数据集的主要特点在于其高质量和多样性。该数据集涵盖了18种语言方向,使用了多种高质量的机器翻译系统生成的翻译,确保了数据的广泛性和代表性。此外,通过结合人类评估和自动指标,MT-PREF数据集在反映人类偏好方面具有较高的准确性。数据集的构建过程中,特别关注了自动指标与人类偏好的一致性,确保了数据集在训练机器翻译模型时的有效性和可靠性。

使用方法

MT-PREF数据集主要用于训练和优化机器翻译模型,特别是那些基于大规模语言模型(LLM)的翻译系统。通过使用MT-PREF数据集进行训练,模型可以更好地理解和模拟人类的翻译偏好,从而提高翻译质量。具体使用方法包括将数据集中的偏好对作为训练样本,利用现有的偏好学习算法(如直接偏好优化DPO和对比偏好优化CPO)来调整模型参数,以最小化偏好损失。此外,MT-PREF数据集还可以用于评估和比较不同机器翻译系统的性能,以及开发和测试新的自动质量评估指标。

背景与挑战

背景概述

在机器翻译(MT)领域,对齐人类偏好是开发准确且安全的大型语言模型的重要步骤。然而,基于人类反馈的偏好数据在大规模获取和整理时成本高昂。自动评估指标虽然高效,但可能无法完全匹配人类的期望。MT-PREF数据集由Sweta Agrawal等人于2022年后创建,涵盖18种语言方向,包含18,000个实例,主要研究人员来自Instituto de Telecomunicações、Unbabel等机构。该数据集通过结合专业语言学家的句子级质量评估和现有自动评估指标的能力,旨在平衡自动化和人类反馈的优势,显著提升了WMT23和FLORES基准上的翻译质量。

当前挑战

MT-PREF数据集面临的挑战包括:1) 解决图像分类等领域的具体问题时,如何确保自动评估指标与人类偏好高度一致;2) 在构建过程中,如何有效整合多语言、多领域的文本数据,确保数据集的多样性和高质量。此外,数据集的创建需克服大规模收集和整理人类反馈的高成本问题,以及自动评估指标可能无法完全反映人类期望的局限性。

常用场景

经典使用场景

MT-PREF数据集在机器翻译领域中被广泛用于模型训练和评估,特别是在对齐大型语言模型(LLMs)与人类偏好方面。该数据集通过收集专业语言学家的句子级质量评估,并利用自动质量评估(QE)指标来恢复这些偏好,从而创建了一个包含18种语言方向的高质量偏好数据集。经典使用场景包括使用MT-PREF数据集对TOWER模型进行微调,以显著提高其在WMT23和FLORES基准测试中的翻译质量。

衍生相关工作

MT-PREF数据集的发布和应用催生了一系列相关研究和工作。例如,Xu et al. (2024) 使用FLORES-200数据集创建了ALMA-R-PREF偏好数据集,并探讨了不同偏好优化方法的效果。此外,MT-PREF数据集还激发了对自动质量评估(QE)指标的进一步研究,特别是在如何更准确地反映人类翻译偏好方面。这些研究不仅扩展了MT-PREF的应用范围,还为机器翻译领域的未来发展提供了新的思路和方法。

数据集最近研究

最新研究方向

在机器翻译(MT)领域,MT-PREF数据集的最新研究方向主要集中在利用自动评估指标来模拟用户偏好,从而提升翻译质量。研究者们通过收集专业语言学家的句子级质量评估,分析当前自动评估指标在恢复这些偏好方面的能力,进而创建了一个包含18种语言方向的高质量偏好数据集。该数据集的引入显著改善了WMT23和FLORES基准测试中的翻译质量,特别是在非英语方向的翻译中表现尤为突出。此外,研究还探讨了不同偏好优化算法对模型性能的影响,发现结合行为克隆正则化的对比偏好优化(CPO)方法在提升翻译质量和模型对人类偏好的建模能力方面表现最佳。

相关研究论文

- 1Modeling User Preferences with Automatic Metrics: Creating a High-Quality Preference Dataset for Machine Translation电信研究所, 高等技术学院, 里斯本大学, Unbabel, ELLIS里斯本单位, 卡内基梅隆大学, MICS, 中央理工-高等电力学院, 巴黎-萨克雷大学 · 2024年

以上内容由AI搜集并总结生成