AudioSetCaps|音频-语言多模态数据集|多模态数据数据集

收藏huggingface2024-10-23 更新2024-12-12 收录

下载链接:

https://huggingface.co/datasets/baijs/AudioSetCaps

下载链接

链接失效反馈资源简介:

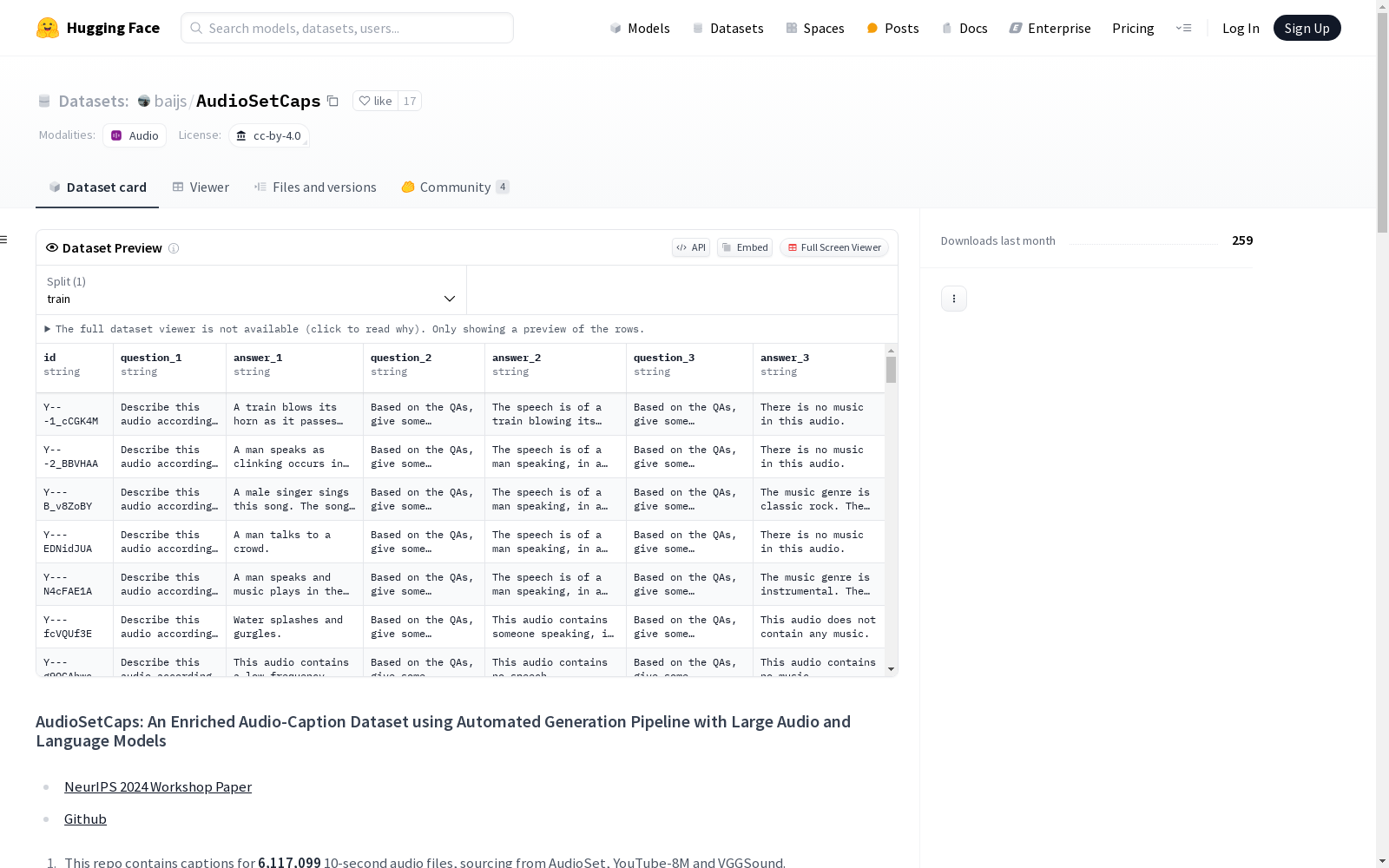

AudioSetCaps是一个丰富的音频-字幕数据集,通过使用大型音频和语言模型的自动化生成管道创建。数据集包含6,117,099个10秒的音频文件,这些文件来源于AudioSet、YouTube-8M和VGGSound。此外,数据集还提供了每个音频的中间Q&A结果,总计18,414,789对Q&A数据。数据集旨在促进未来音频-语言多模态研究的发展。

创建时间:

2024-10-21

原始信息汇总

AudioSetCaps: An Enriched Audio-Caption Dataset using Automated Generation Pipeline with Large Audio and Language Models

数据集概述

- 数据来源: AudioSet, YouTube-8M, VGGSound

- 音频文件数量: 6,117,099个10秒音频文件

- Q&A数据对数量: 18,414,789对

数据集内容

- 音频描述: 每个音频文件附有一个描述性标题。

- Q&A对: 每个音频文件附有三个Q&A对,作为生成最终标题的元数据。

示例

| ID | 音频 | 描述 | Q&A 1 | Q&A 2 | Q&A 3 |

|---|---|---|---|---|---|

| _7Xe9vD3Hpg_4_10 | <audio controls><source src="Example /_7Xe9vD3Hpg_4_10.mp3" type="audio/mpeg"> Your browser does not support the audio element.</audio> | A solemn instrumental piece unfolds, featuring the melancholic strains of a cello and the resonant tolling of a bell. The initial tempo is slow and deliberate, gradually building intensity with each successive bell ring. | Question: Describe this audio according to the sounds in it. Answer: The music starts with a slow string melody and continues with a bass note. The sound of a bell rings and the music becomes more intense. | Question: Based on the QAs, give some information about the speech, such as the emotion of the speaker, the gender of the speaker, and the spoken language, only if speech is present in this audio. Answer: Im sorry, but there is no speech in the audio. | Question: Based on the QAs, give some information about the music, such as music genre and music instruments, only if music is present in this audio. Answer: The music genre is instrumental. The music instruments are the cello and the bell. |

| -TL8Mp3xcUM_0_10 | <audio controls><source src="Example/-TL8Mp3xcUM_0_10.mp3" type="audio/mpeg"> Your browser does not support the audio element.</audio> | A woman expresses strong emotions with a noticeably high-pitched vocal tone. | Question: Describe this audio according to the sounds in it. Answer: A woman speaks with a high-pitched voice. | Question: Based on the QAs, give some information about the speech, such as the emotion of the speaker, the gender of the speaker, and the spoken language, only if speech is present in this audio. Answer: The speech is emotional, as the woman speaks in a high-pitched voice. | Question: Based on the QAs, give some information about the music, such as music genre and music instruments, only if music is present in this audio. Answer: There is no music in this audio. |

数据统计

| 数据集 | 音频描述数量 | Q&A描述数量 | 总计 |

|---|---|---|---|

| AudioSetCaps | 1910920 | 5736072 | 7646992 |

| YouTube-8M | 4023990 | 12086037 | 16110027 |

| VGGSound | 182189 | 592680 | 774869 |

| 总计 | 6117099 | 18414789 | 24531888 |

下载

许可证

- 仅允许学术用途

引用

bibtex @inproceedings{ bai2024audiosetcaps, title={AudioSetCaps: Enriched Audio Captioning Dataset Generation Using Large Audio Language Models}, author={JISHENG BAI and Haohe Liu and Mou Wang and Dongyuan Shi and Wenwu Wang and Mark D Plumbley and Woon-Seng Gan and Jianfeng Chen}, booktitle={Audio Imagination: NeurIPS 2024 Workshop AI-Driven Speech, Music, and Sound Generation}, year={2024}, url={https://openreview.net/forum?id=uez4PMZwzP} }

AI搜集汇总

数据集介绍

构建方式

AudioSetCaps数据集的构建依托于大规模音频与语言模型的自动化生成管道,涵盖了来自AudioSet、YouTube-8M和VGGSound的6,117,099段10秒音频文件。每段音频均配有一段描述性文本,并附有三组问答对,作为生成最终描述的元数据。这一构建过程不仅确保了数据的丰富性,还通过问答对的引入增强了音频与文本之间的关联性。

特点

AudioSetCaps数据集的特点在于其规模庞大且内容多样,涵盖了广泛的音频场景与语言描述。数据集不仅提供了音频的描述性文本,还包含了18,414,789组问答对,这些问答对进一步丰富了音频的语义信息。此外,数据集中还包含了AudioCaps和VGGSound的评估集,为研究者提供了更为全面的实验数据。

使用方法

使用AudioSetCaps数据集时,研究者可通过下载提供的音频描述与问答对数据进行多模态研究。为避免评估数据的干扰,建议在模型训练前对数据集进行预过滤,排除评估集数据。数据集的使用仅限于学术研究,下载即表示同意仅用于研究目的。通过引用相关论文,研究者可进一步了解数据集的构建细节与应用场景。

背景与挑战

背景概述

AudioSetCaps数据集由Jisheng Bai等人于2024年提出,旨在通过结合大规模音频与语言模型,为音频-文本多模态研究提供丰富的标注数据。该数据集基于AudioSet、YouTube-8M和VGGSound等现有音频资源,生成了超过600万条10秒音频的文本描述,并提供了1800万条问答对作为中间生成结果。其核心研究问题在于如何利用自动化生成管道,提升音频描述的质量与多样性,从而推动音频-语言多模态领域的研究进展。AudioSetCaps的发布为音频理解、生成与检索等任务提供了重要的数据支持,显著扩展了相关研究的可能性。

当前挑战

AudioSetCaps数据集在解决音频描述生成问题时面临多重挑战。首先,音频内容的多样性与复杂性使得生成准确且语义丰富的文本描述变得困难,尤其是在处理多源音频数据时,如何保持描述的一致性与质量成为关键问题。其次,数据集的构建过程中,自动化生成管道的设计与优化需要克服大规模数据处理与模型训练的瓶颈,确保生成结果的可靠性与高效性。此外,数据集中包含的评估集数据可能对模型训练产生干扰,需通过预过滤机制加以处理,以避免数据泄露问题。这些挑战共同构成了AudioSetCaps在推动音频-语言多模态研究中的核心难点。

常用场景

经典使用场景

AudioSetCaps数据集在音频-语言多模态研究领域中具有广泛的应用。该数据集通过自动化生成管道,结合大规模音频和语言模型,为超过600万条10秒音频片段提供了丰富的文本描述和问答对。这些数据为研究人员提供了宝贵的资源,用于训练和评估音频描述生成模型,尤其是在音频内容理解和跨模态对齐任务中表现出色。

实际应用

在实际应用中,AudioSetCaps数据集被广泛用于开发智能音频处理系统,如自动音频描述生成、音频内容检索和跨模态搜索等。这些系统在多媒体内容管理、辅助技术(如为视障人士提供音频描述)以及智能语音助手中具有重要应用价值。通过利用该数据集,研究人员和开发者能够构建更加精准和智能的音频处理工具,提升用户体验。

衍生相关工作

AudioSetCaps数据集衍生了一系列经典研究工作,特别是在音频描述生成和跨模态学习领域。基于该数据集,研究人员开发了多种先进的音频-语言模型,如基于Transformer的音频描述生成模型和跨模态对齐模型。这些工作不仅在学术界引起了广泛关注,还为工业界提供了实用的技术解决方案,推动了音频处理技术的进一步发展。

以上内容由AI搜集并总结生成