DAHL|生物医学数据集|模型评估数据集

收藏arXiv2024-11-14 更新2024-11-16 收录

下载链接:

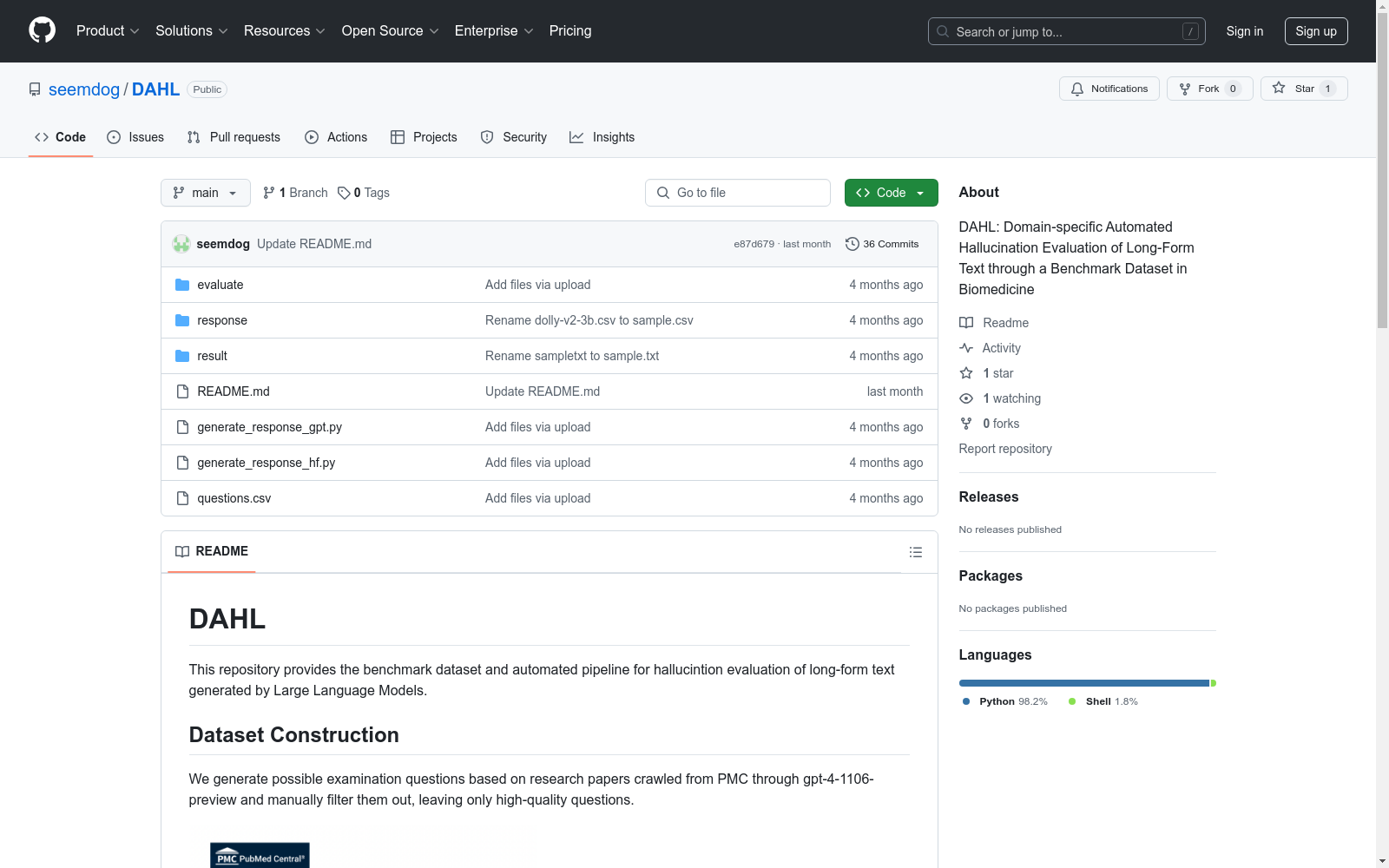

https://github.com/seemdog/DAHL

下载链接

链接失效反馈资源简介:

DAHL是由首尔国立大学精心策划的生物医学领域长篇文本生成幻觉评估基准数据集。该数据集包含8,573个问题,涵盖29个类别,来源于PubMed Central的生物医学研究论文。数据集的创建过程包括自动生成问题和人工筛选,确保问题的高质量和独立可答性。DAHL旨在评估大型语言模型在生物医学领域的幻觉问题,通过将模型响应分解为原子单位来计算事实准确性,从而提供比传统多选任务更深入的评估。该数据集的应用领域主要集中在生物医学和临床应用,旨在解决模型生成文本中的事实冲突问题。

提供机构:

首尔国立大学

创建时间:

2024-11-14

原始信息汇总

DAHL 数据集概述

数据集构建

- 来源:基于从PMC爬取的研究论文生成可能的考试问题。

- 生成方式:使用gpt-4-1106-preview生成问题,并手动筛选出高质量问题。

评估流程

- 自动化评估流程:包括两个阶段:

- 将响应分割成原子单位。

- 检查每个原子单位的事实性。

安装与使用

-

安装: bash git clone https://github.com/seemdog/DAHL.git cd DAHL

-

响应生成:

-

Huggingface模型: bash python generate_response_hf.py --model meta-llama/Meta-Llama-3-8B-Instruct --temperature 0.6 --max_new_tokens 256

-

OpenAI模型: bash python generate_response_gpt.py --model gpt-4o --api_key YOUR_API_KEY --temperature 0.6

-

-

评估: bash cd evaluate sh run.sh model_to_evaluate openAI_API_key perplexityAI_API_key model_to_use_perplexityAI

结果保存

- 最终DAHL评分:将保存在一个

.txt文件中。

引用

- 引用信息:待定(TBD)。

AI搜集汇总

数据集介绍

构建方式

DAHL数据集的构建过程严谨而系统,源自PubMed Central(PMC)的2,519篇生物医学研究论文。通过gpt-4-1106-preview生成可能的考试问题,并经过过滤过程,确保问题能够独立回答,无需额外信息。最终,数据集包含8,573个问题,分布在29个不同的类别中,涵盖了广泛的生物医学文献。

使用方法

DAHL数据集的使用方法包括首先对模型生成的响应进行预处理,去除提示和重复句子,然后使用gpt-4o模型将响应分割成原子单位。接着,通过pplx-API检查每个原子单位的事实准确性,并计算每个响应的事实准确性比例,最终得出DAHL评分。该评分可用于评估模型在生物医学领域长篇文本生成中的幻觉倾向,并可作为偏好数据集用于对齐调优。

背景与挑战

背景概述

DAHL数据集由首尔国立大学的Jean Seo、Jongwon Lim、Dongjun Jang和Hyopil Shin团队于2024年创建,专注于评估长篇文本生成中的幻觉现象,特别是在生物医学领域。该数据集精心从生物医学研究论文中筛选出8,573个问题,涵盖29个类别,旨在通过分解模型生成的响应为原子单位来评估事实冲突幻觉。DAHL不仅提供了一种更深入的幻觉评估方法,还通过DAHL评分系统为模型提供了更细致的评估,从而填补了现有评估方法在生物医学领域中的空白。

当前挑战

DAHL数据集面临的挑战主要包括两个方面:一是解决领域特定问题,即在生物医学领域中,长篇文本生成任务的幻觉评估需要更为细致和精确,而现有的多选题或依赖人工注释的方法难以满足这一需求;二是数据集构建过程中的挑战,如从PubMed Central中筛选高质量问题、确保问题分类的准确性以及自动化评估系统的可靠性。此外,如何在不依赖人工注释的情况下,实现对长篇文本生成任务的准确评估,也是DAHL需要克服的重要难题。

常用场景

经典使用场景

DAHL数据集在生物医学领域中被广泛用于评估大型语言模型(LLMs)在长文本生成中的幻觉现象。通过将生成的文本分解为原子单位,DAHL能够精确计算每个单位的事实准确性,从而提供一个全面的幻觉评估框架。这种细粒度的评估方法使得DAHL在检测和量化生物医学文本中的事实冲突幻觉方面具有显著优势。

解决学术问题

DAHL数据集解决了在生物医学领域中评估LLMs幻觉现象的学术难题。传统方法主要依赖于多选题或人工注释,这些方法在评估长文本生成时存在局限性。DAHL通过自动化的原子单位分解和事实准确性计算,提供了一种高效且准确的评估手段,填补了现有评估资源的空白,为LLMs在生物医学文本生成中的可靠性研究提供了重要工具。

实际应用

DAHL数据集在实际应用中主要用于生物医学领域的文本生成质量控制。例如,在临床报告生成、医学语言翻译和医疗支持系统中,DAHL可以帮助检测和纠正生成的文本中的幻觉现象,确保信息的准确性和可靠性。此外,DAHL的自动化评估系统可以显著减少人工注释的成本和时间,提高评估效率,适用于大规模的文本生成任务。

数据集最近研究

最新研究方向

在生物医学领域,长文本生成中的幻觉评估成为一个备受关注的前沿课题。DAHL数据集的最新研究聚焦于通过自动化系统评估大型语言模型(LLMs)在长文本生成中的事实冲突幻觉。该研究不仅构建了一个包含8,573个问题、涵盖29个类别的基准数据集,还提出了一种新颖的评估方法——DAHL评分,通过将模型生成的响应分解为原子单位来计算事实准确性。这种方法相较于依赖多选任务或人工注释的传统评估方式,提供了更为细致和全面的幻觉评估。此外,研究还探讨了模型规模对幻觉率的影响,发现模型规模在达到7至8亿参数后,进一步扩大规模对事实准确性的提升效果有限。这一发现为未来在生物医学等高风险领域中优化和部署LLMs提供了重要参考。

相关研究论文

- 1DAHL: Domain-specific Automated Hallucination Evaluation of Long-Form Text through a Benchmark Dataset in Biomedicine首尔国立大学 · 2024年

以上内容由AI搜集并总结生成