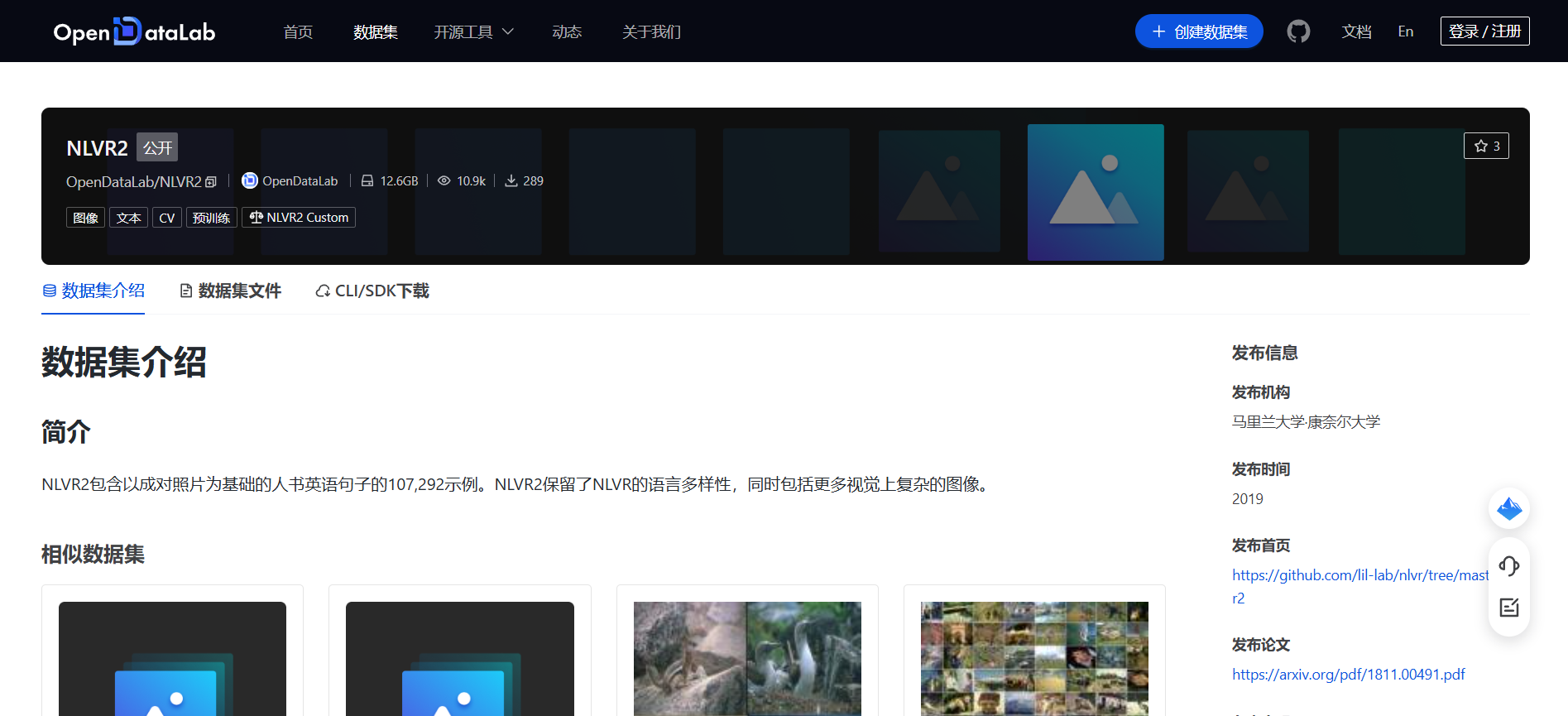

NLVR2|自然语言处理数据集|计算机视觉数据集

收藏

- NLVR2数据集首次发表,由斯坦福大学和艾伦人工智能研究所共同开发,旨在评估视觉推理能力。

- NLVR2数据集首次应用于视觉推理任务,成为评估模型在复杂视觉场景中理解和推理能力的重要基准。

- NLVR2数据集被广泛应用于多个研究项目,推动了视觉推理领域的技术进步和模型优化。

- NLVR2数据集的扩展版本发布,增加了更多的图像和语言对,进一步提升了数据集的多样性和挑战性。

- NLVR2数据集在多个国际会议和竞赛中被用作基准测试,促进了视觉推理研究的国际交流与合作。

- 1From Recognition to Cognition: Visual Commonsense ReasoningUniversity of Washington, Allen Institute for AI · 2019年

- 2Unified Vision-Language Pre-Training for Image Captioning and VQAUniversity of Adelaide, Tsinghua University · 2020年

- 3LXMERT: Learning Cross-Modality Encoder Representations from TransformersUniversity of North Carolina at Chapel Hill, University of Washington · 2019年

- 4ViLBERT: Pretraining Task-Agnostic Visiolinguistic Representations for Vision-and-Language TasksUniversity of California, Berkeley, Facebook AI Research · 2019年

- 5UNITER: UNiversal Image-TExt Representation LearningMicrosoft Research Asia, Tsinghua University · 2020年

ROBEL

ROBEL是一个开源的低成本机器人平台,专为现实世界的强化学习设计。该平台由谷歌研究院和加州大学伯克利分校共同开发,包含两个机器人:D'Claw,一个三指手机器人,用于促进精细操作任务的学习;D'Kitty,一个四足机器人,用于促进敏捷的腿式移动任务学习。这些模块化机器人易于维护且足够坚固,能够承受从零开始的硬件强化学习,目前已记录超过14000小时的训练时间。ROBEL提供了一系列连续控制基准任务,这些任务具有密集和稀疏的任务目标,并引入了硬件安全评分指标。数据集和相关材料可在www.roboticsbenchmarks.org访问,旨在解决强化学习在真实机器人上的应用问题,特别是在处理物理限制和环境交互方面的挑战。

arXiv 收录

学生课堂行为数据集 (SCB-dataset3)

学生课堂行为数据集(SCB-dataset3)由成都东软学院创建,包含5686张图像和45578个标签,重点关注六种行为:举手、阅读、写作、使用手机、低头和趴桌。数据集覆盖从幼儿园到大学的不同场景,通过YOLOv5、YOLOv7和YOLOv8算法评估,平均精度达到80.3%。该数据集旨在为学生行为检测研究提供坚实基础,解决教育领域中学生行为数据集的缺乏问题。

arXiv 收录

CAP-DATA

CAP-DATA数据集由长安大学交通学院的研究团队创建,包含11,727个交通事故视频,总计超过2.19百万帧。该数据集不仅标注了事故发生的时间窗口,还提供了详细的文本描述,包括事故前的实际情况、事故类别、事故原因和预防建议。数据集的创建旨在通过结合视觉和文本信息,提高交通事故预测的准确性和解释性,从而支持更安全的驾驶决策系统。

arXiv 收录

MedDialog

MedDialog数据集(中文)包含了医生和患者之间的对话(中文)。它有110万个对话和400万个话语。数据还在不断增长,会有更多的对话加入。原始对话来自好大夫网。

github 收录

Obstacle-dataset OD

该数据集用于十五种障碍物检测,包含VOC格式和YOLO训练的.txt文件,数据集中的图像来自VOC数据集、COCO数据集、TT100K数据集以及作者团队实地收集的图片。

github 收录