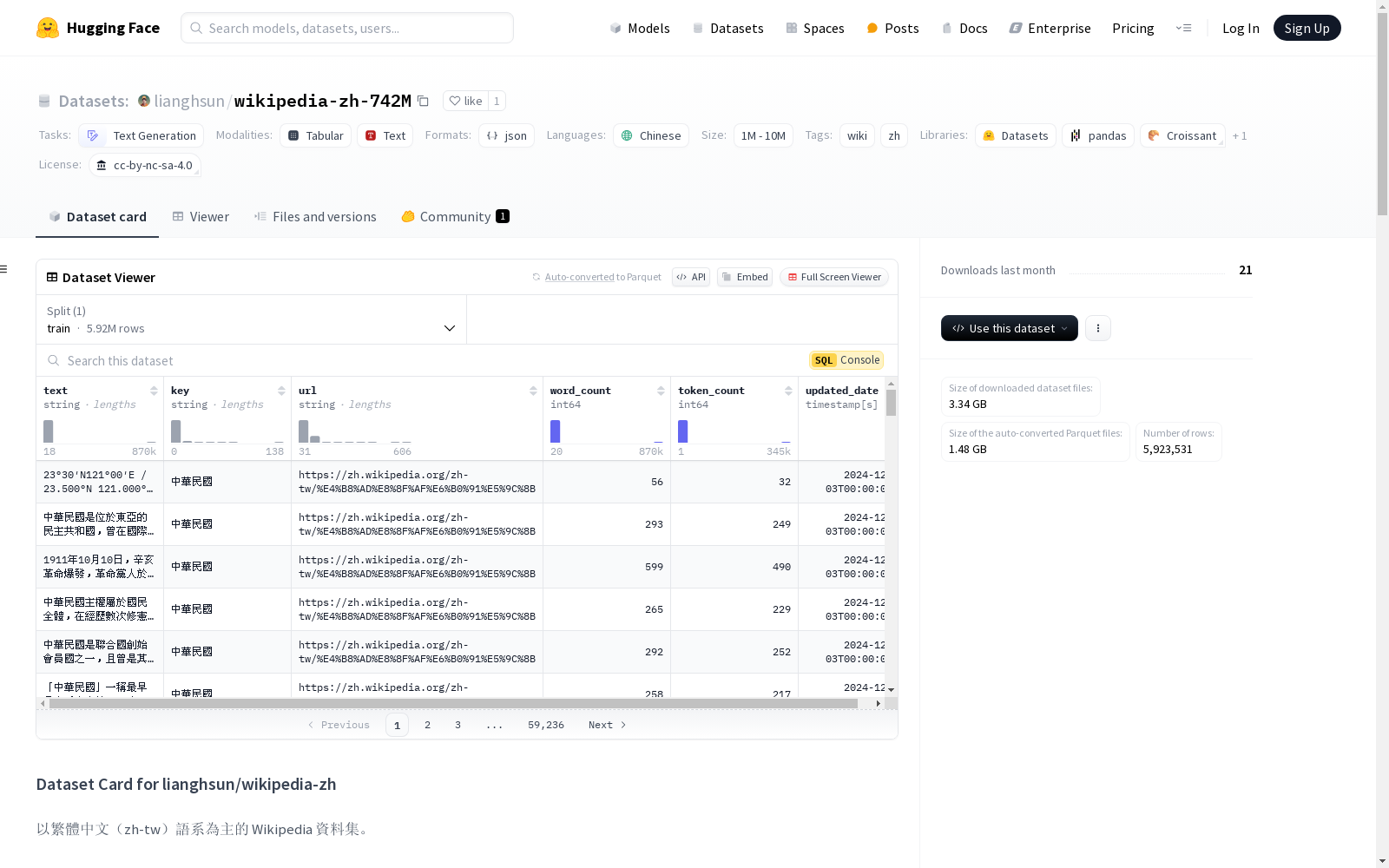

wikipedia-zh-742M|自然语言处理数据集|繁体中文数据集

收藏huggingface2024-12-09 更新2024-12-12 收录

下载链接:

https://huggingface.co/datasets/lianghsun/wikipedia-zh-742M

下载链接

资源简介:

本数据集由自行开发的爬虫从Wikipedia上抓取标注为繁体中文(zh-tw)的文本内容,确保文本语系是繁体中文。数据集涵盖广泛,可能包含政治不正确或非客观的信息,使用时需谨慎评估。数据集已切分为多个子语料,便于训练。数据集包含742,565,363个tokens,但可能尚未包含全部繁体中文内容,将不定期更新。

开放时间:

2024-12-05

创建时间:

2024-12-05

原始信息汇总

数据集卡片:lianghsun/wikipedia-zh

数据集概述

以繁體中文(zh-tw)语系为主的 Wikipedia 资料集。

数据集详情

数据集描述

本数据集由自行开发的爬虫抓取 Wikipedia 上标注繁體中文语系(zh-tw)的文本内容,以确保文本语系是繁體中文。目前 Hugging Face 上标注为繁體中文语系的许多 Wikipedia 资料集,其实并非真正的 Wikipedia 资料集,而是来自 Wikimedia 的内容。本数据集涵盖范围广泛,不仅限于台湾,也包含其他国家的内容,因此可能包含 政治不正确 或 非客观 的信息,使用时请谨慎评估。

为便于训练,同一个 Wikipedia 页面的语料已被切分为多个子语料,用户可依需求进行合并处理。

本数据集经 meta-llama/Llama-3.2-1B 统计共有 742,565,363 tokens。

附注:爬虫程序中断在某个时间,故数据集可能尚未包含全部繁體中文的内容,将不定期更新此数据集。

数据集来源

- Repository: lianghsun/wikipedia-zh

语言

- 繁體中文

许可证

- cc-by-nc-sa-4.0

标签

- wiki

- zh

数据集大小

- 1M<n<10M

数据集创建者

使用

直接使用

[更多信息待补充]

超出范围的使用

再次强调:本数据集涵盖范围广泛,不仅限于台湾,也包含其他国家的内容,因此可能包含 政治不正确 或 非客观 的信息,使用时请谨慎评估。

数据集结构

[更多信息待补充]

数据集创建

数据集创建动机

[更多信息待补充]

源数据

数据收集和处理

[更多信息待补充]

源数据生产者

注释

注释过程

[更多信息待补充]

注释者

[更多信息待补充]

个人和敏感信息

[更多信息待补充]

偏见、风险和限制

再次强调:本数据集涵盖范围广泛,不仅限于台湾,也包含其他国家的内容,因此可能包含 政治不正确 或 非客观 的信息,使用时请谨慎评估。

建议

用户应了解数据集的风险、偏见和技术限制。更多信息待补充以提供进一步建议。

引用

[更多信息待补充]

术语表

[更多信息待补充]

更多信息

[更多信息待补充]

数据集卡片作者

数据集卡片联系人

AI搜集汇总

数据集介绍

构建方式

该数据集通过自主开发的爬虫程序,从Wikipedia上抓取了标注为繁体中文(zh-tw)的文本内容,确保了语料的纯正性。与许多标注为繁体中文的Wikipedia数据集不同,本数据集直接来源于Wikipedia,而非Wikimedia的转储内容。为了便于训练,同一页面内容被切分为多个子语料,用户可根据需求进行合并处理。数据集的构建过程中,爬虫程序在某时刻中断了抓取,因此可能尚未包含所有繁体中文内容,后续将不定期更新。

使用方法

该数据集适用于文本生成任务,用户可以直接使用其进行模型训练或预训练。由于数据集已被切分为多个子语料,用户可以根据具体需求选择合适的子语料进行合并或单独使用。在使用过程中,需注意数据集中可能存在的政治不正确或非客观信息,建议在使用前进行必要的筛选和处理。

背景与挑战

背景概述

wikipedia-zh-742M数据集是由Huang Liang Hsun开发并维护的繁体中文Wikipedia文本数据集,旨在提供高质量的繁体中文语料。该数据集通过自主开发的爬虫程序从Wikipedia上抓取标注为繁体中文(zh-tw)的文本内容,确保语料的纯正性。与许多现有的繁体中文Wikipedia数据集不同,该数据集直接来源于Wikipedia,而非Wikimedia的转储内容。数据集的创建时间为近期,主要研究人员为Huang Liang Hsun,其核心研究问题是如何为自然语言处理任务提供高质量的繁体中文语料。该数据集的发布对繁体中文自然语言处理领域具有重要意义,尤其在文本生成和语言模型训练方面提供了丰富的资源。

当前挑战

wikipedia-zh-742M数据集在构建过程中面临多项挑战。首先,确保数据集的语料纯正性是一个重要挑战,因为许多现有的繁体中文Wikipedia数据集并非直接来源于Wikipedia。其次,数据集的构建过程中,爬虫程序可能在中断时未能抓取所有繁体中文内容,导致数据集的完整性受到影响。此外,数据集中可能包含政治不正确或非客观的信息,这要求使用者在应用时进行谨慎评估。最后,数据集的更新频率和覆盖范围也是一个持续的挑战,以确保数据集能够反映最新的Wikipedia内容。

常用场景

经典使用场景

wikipedia-zh-742M数据集以其丰富的繁体中文文本内容,成为自然语言处理领域中进行文本生成、语言模型训练的经典数据集。该数据集广泛应用于构建和优化繁体中文语言模型,尤其是在大规模预训练模型中,其高质量的文本数据为模型提供了丰富的语境和词汇多样性,从而显著提升了模型的语言理解和生成能力。

解决学术问题

wikipedia-zh-742M数据集解决了繁体中文自然语言处理领域中数据稀缺的问题。由于繁体中文资源相对较少,该数据集的推出为研究人员提供了宝贵的语料库,使得在语言模型、文本分类、信息抽取等任务中能够进行更深入的研究。其广泛的内容覆盖范围和高质量的文本数据,为学术界提供了丰富的研究素材,推动了相关领域的发展。

实际应用

在实际应用中,wikipedia-zh-742M数据集被广泛用于构建智能客服、自动翻译系统、内容推荐引擎等。其丰富的文本内容和多样化的主题使得这些应用能够更好地理解和生成繁体中文文本,从而提升用户体验。此外,该数据集还被用于教育领域的智能辅导系统,帮助学生更高效地学习繁体中文。

数据集最近研究

最新研究方向

在自然语言处理领域,繁体中文文本的生成与理解一直是研究的热点之一。wikipedia-zh-742M数据集的推出,为繁体中文的文本生成任务提供了丰富的语料资源。该数据集不仅涵盖了广泛的主题,还通过精细的语料切分,为研究者提供了灵活的处理方式。近年来,随着大规模预训练模型在多语言环境中的成功应用,繁体中文的文本生成模型也取得了显著进展。研究者们正利用该数据集探索如何在保持语言多样性的同时,提升模型的生成质量和语义理解能力。此外,数据集中潜在的政治敏感性和非客观信息也为研究者提出了新的挑战,促使他们在模型训练中引入更加严谨的筛选和校正机制,以确保生成内容的准确性和中立性。

以上内容由AI搜集并总结生成