维基百科中文语料|自然语言处理数据集|文本挖掘数据集

收藏wikicorpus

数据集概述

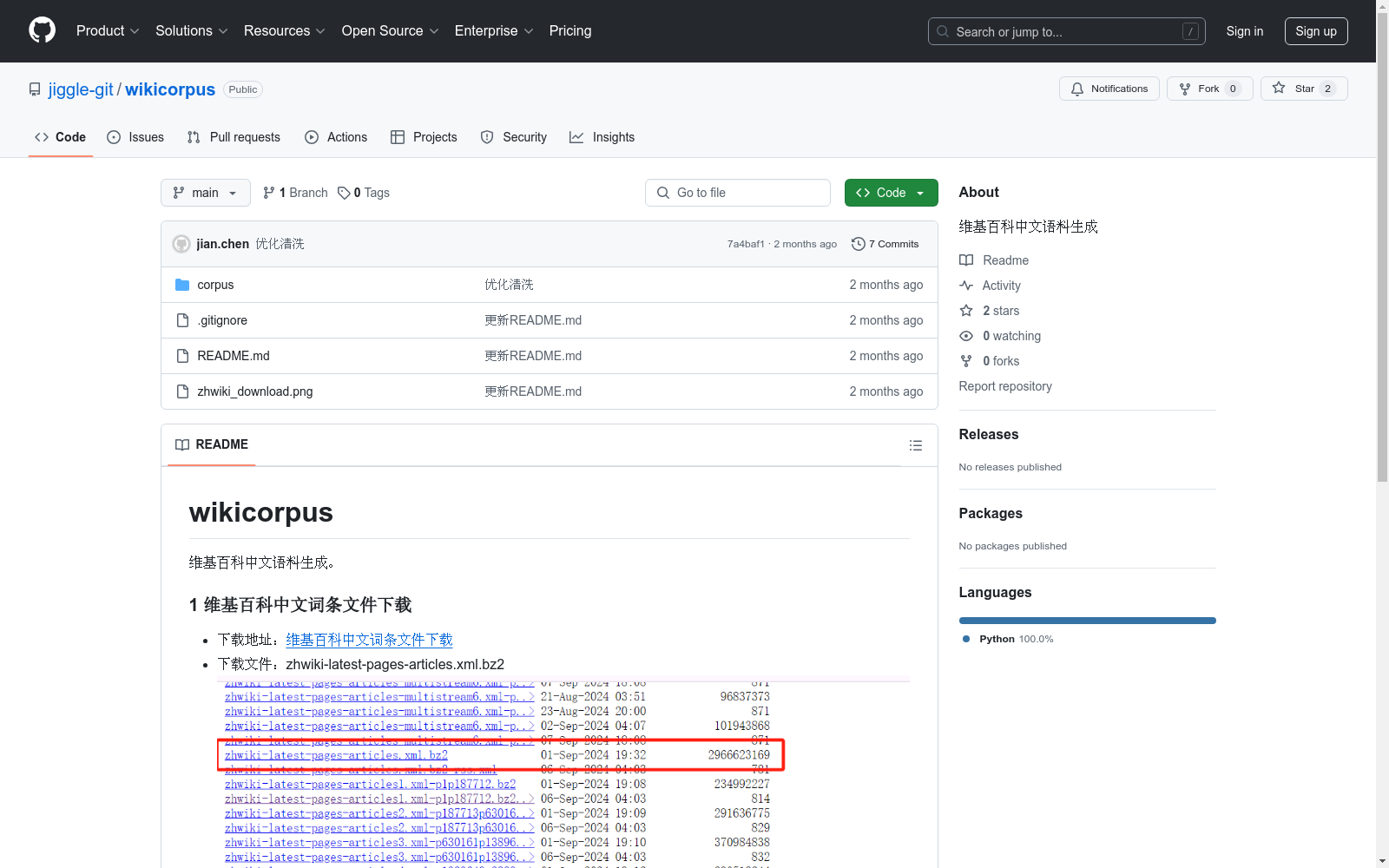

wikicorpus 是一个用于生成维基百科中文语料的数据集。

数据集内容

1 维基百科中文词条文件下载

- 下载地址:维基百科中文词条文件下载

- 下载文件:zhwiki-latest-pages-articles.xml.bz2

2 维基百科中文语料生成

2.1 提取 wiki_extractor

- 词条文件解析:文件内容为 XML 格式,使用 xml.etree 解析

- 提取结果:词条标题, 词条内容, 词条id

2.2 清洗 wiki_cleaner

- 繁体转为简体:使用 opencc 转换为简体中文

- 词条内容解析:使用 mwparserfromhell 解析并进行处理

- 其他清洗规则:正则替换指定字符、去除空格、合并多个换行等

2.3 生成 wiki_generator

- 读取词条文件:文件为 bz2 格式,使用 bz2file 读取词条文件

- 提取词条数据:wiki_extractor

- 生成语料文件:生成的文件格式为 jsonl 格式,每一行为一条语料数据,格式为:{"id": "词条id", "title": "词条标题", "content": "词条内容"}

LFW

人脸数据集;LFW数据集共有13233张人脸图像,每张图像均给出对应的人名,共有5749人,且绝大部分人仅有一张图片。每张图片的尺寸为250X250,绝大部分为彩色图像,但也存在少许黑白人脸图片。 URL: http://vis-www.cs.umass.edu/lfw/index.html#download

AI_Studio2024-03-04 收录

AgiBot World

为了进一步推动通用具身智能领域研究进展,让高质量机器人数据触手可及,作为上海模塑申城语料普惠计划中的一份子,智元机器人携手上海人工智能实验室、国家地方共建人形机器人创新中心以及上海库帕思,重磅发布全球首个基于全域真实场景、全能硬件平台、全程质量把控的百万真机数据集开源项目 AgiBot World。这一里程碑式的开源项目,旨在构建国际领先的开源技术底座,标志着具身智能领域 「ImageNet 时刻」已到来。AgiBot World 是全球首个基于全域真实场景、全能硬件平台、全程质量把控的大规模机器人数据集。相比于 Google 开源的 Open X-Embodiment 数据集,AgiBot World 的长程数据规模高出 10 倍,场景范围覆盖面扩大 100 倍,数据质量从实验室级上升到工业级标准。AgiBot World 数据集收录了八十余种日常生活中的多样化技能,从抓取、放置、推、拉等基础操作,到搅拌、折叠、熨烫等精细长程、双臂协同复杂交互,几乎涵盖了日常生活所需的绝大多数动作需求。

github2024-12-30 收录

CAP-DATA

CAP-DATA数据集由长安大学交通学院的研究团队创建,包含11,727个交通事故视频,总计超过2.19百万帧。该数据集不仅标注了事故发生的时间窗口,还提供了详细的文本描述,包括事故前的实际情况、事故类别、事故原因和预防建议。数据集的创建旨在通过结合视觉和文本信息,提高交通事故预测的准确性和解释性,从而支持更安全的驾驶决策系统。

arXiv2024-06-21 收录

Plant-Diseases

Dataset for Plant Diseases containg variours Plant Disease

kaggle2024-07-13 收录

HyperGlobal-450K - 全球最大规模高光谱图像数据集

HyperGlobal-450K数据集由武汉大学联合国内外多所知名高校及研究机构共同构建,是迄今为止全球规模最大的高光谱图像数据集。该数据集包含约45万张高光谱图像,规模等价于超过2000万张不重叠的三波段图像,远超现有的同类数据集。数据集涵盖了全球范围内的高光谱遥感图像,包括来自地球观测一号(EO-1)Hyperion和高分五号(GF-5B)两种传感器的图像,光谱范围从可见光到短波及中波红外,具有从紫外到长波红外的330个光谱波段,空间分辨率为30米。每幅图像经过精心处理,去除了无效波段和水汽吸收波段,保留了具有实际应用价值的光谱信息。HyperGlobal-450K数据集不仅支持高光谱图像的基础研究,还能够用于开发和测试各种高光谱图像处理方法,比如图像分类、目标检测、异常检测、变化检测、光谱解混、图像去噪和超分辨率等任务。

github2024-06-19 收录