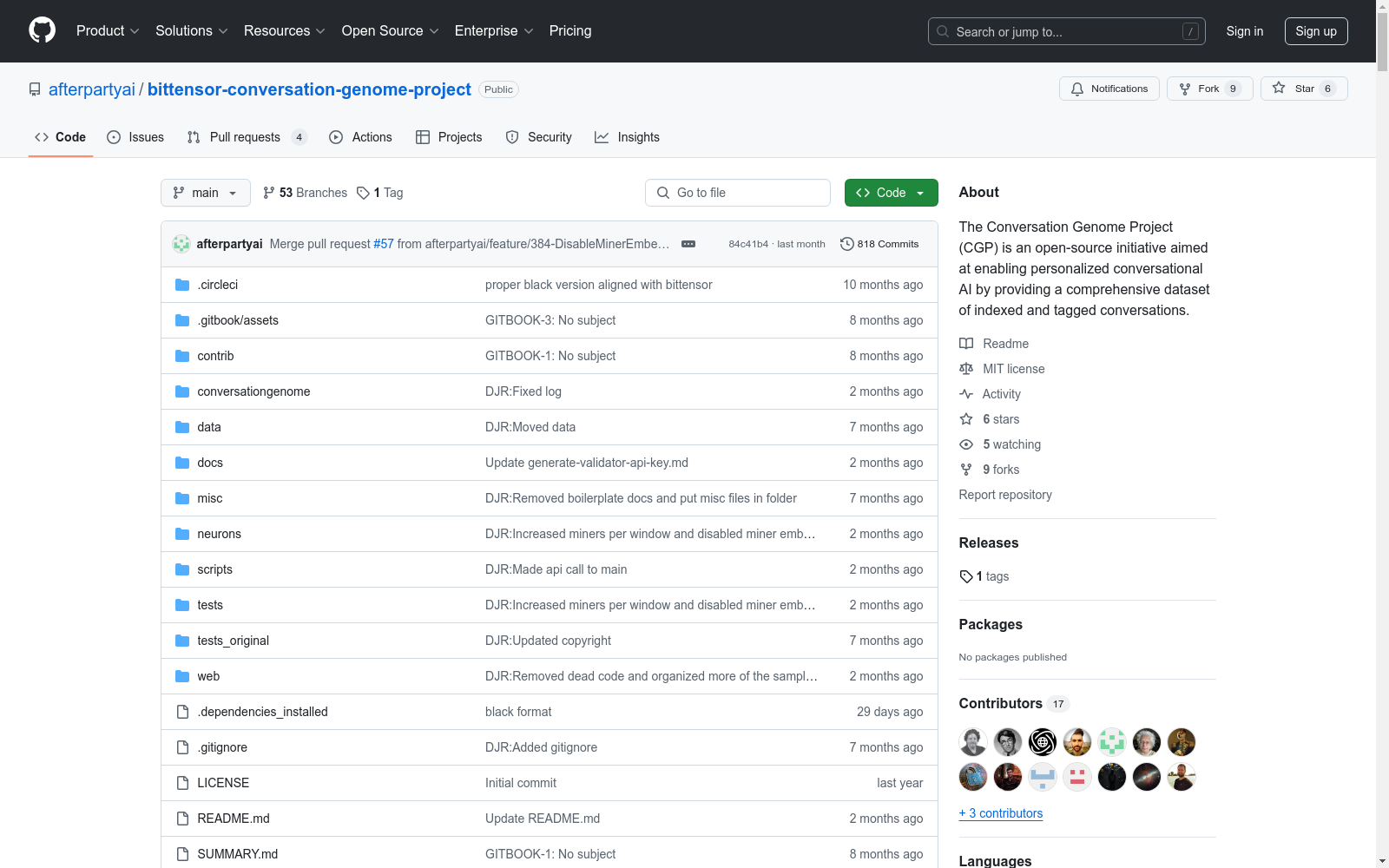

Conversation Genome Project|对话AI数据集|自然语言处理数据集

收藏Conversation Genome Project 数据集概述

数据集描述

Conversation Genome Project (CGP) 是一个开源项目,旨在通过提供一个包含索引和标记的对话的全面数据集,来实现个性化对话AI。该项目利用了Bittensor基础设施来注释与对话相关的数据。

关键特性

- 对来自不同来源(如YouTube、播客等)的数十亿对话进行索引和标记

- 利用分形数据挖掘和对话窗口进行高效且保护隐私的处理

- 从对话元数据生成的合成参与者配置文件

- 评估对话质量的算法(相关性、参与度、新颖性、连贯性和流畅性)

- 用于训练和微调对话AI模型的开源数据集

- 激励数据贡献和完整性的挖矿和验证系统

系统设计

- 数据存储:主要数据源、对话窗口、参与者配置文件和向量数据库

- 验证者角色:拉取数据、为基础对话生成概览元数据、创建窗口并评分提交

- 矿工角色:处理对话窗口、提供元数据和标签

- 数据流程:从CGP API获取对话,通过LLM处理生成标签和元数据,最终存储在数据库中

安装与计算要求

- 需要Python 3.8或更高版本

- 矿工和验证者使用OpenAI API密钥时,需要至少8GB RAM和20GB磁盘空间

配置

- 需要配置

.env文件,包括API密钥和LLM类型选择 - 支持的LLM类型包括OpenAI、Anthropic和groq

测试运行

- 通过运行测试验证器套件来检查配置和环境设置

- 测试包括启动验证器和矿工,处理对话并返回元数据

注册

- 在测试网或主网上注册UID,用于挖矿或验证

子网角色

- 挖矿:使用特定命令启动矿工

- 验证:使用特定命令启动验证器

自定义对话服务器

- 验证器可以运行自己的数据源,处理自定义或专有对话数据

- 提供了一个示例实现,需要根据需求修改

使用Runpod

- 使用Runpod启动和管理云GPU和CPU实例

- 需要特定的配置设置,包括端口映射和实例选择

进程管理

- 推荐使用pm2或Screen管理进程

- pm2的安装和基本使用命令

许可证

- 该项目使用MIT许可证

Yahoo Finance

Dataset About finance related to stock market

kaggle 收录

CE-CSL

CE-CSL数据集是由哈尔滨工程大学智能科学与工程学院创建的中文连续手语数据集,旨在解决现有数据集在复杂环境下的局限性。该数据集包含5,988个从日常生活场景中收集的连续手语视频片段,涵盖超过70种不同的复杂背景,确保了数据集的代表性和泛化能力。数据集的创建过程严格遵循实际应用导向,通过收集大量真实场景下的手语视频材料,覆盖了广泛的情境变化和环境复杂性。CE-CSL数据集主要应用于连续手语识别领域,旨在提高手语识别技术在复杂环境中的准确性和效率,促进聋人与听人社区之间的无障碍沟通。

arXiv 收录

Figshare

Figshare是一个在线数据共享平台,允许研究人员上传和共享各种类型的研究成果,包括数据集、论文、图像、视频等。它旨在促进科学研究的开放性和可重复性。

figshare.com 收录

AQA-7

AQA-7 是一个用于动作质量评估(AQA)的统一基准数据集,旨在通过整合多个领域的数据集来标准化评估方法。该数据集包含视频、骨骼数据和多模态输入,涵盖了体育分析、技能评估和医疗护理等多个应用领域。数据集的创建过程通过系统分析现有文献和实验协议,确保了评估的准确性和计算效率。AQA-7 的应用领域广泛,旨在解决动作质量评估中的偏差问题,提供客观的自动化评估,特别是在体育评分、技能评估和康复训练中具有重要意义。

arXiv 收录

URPC系列数据集, S-URPC2019, UDD

URPC系列数据集包括URPC2017至URPC2020DL,主要用于水下目标的检测和分类。S-URPC2019专注于水下环境的特定检测任务。UDD数据集信息未在README中详细描述。

github 收录