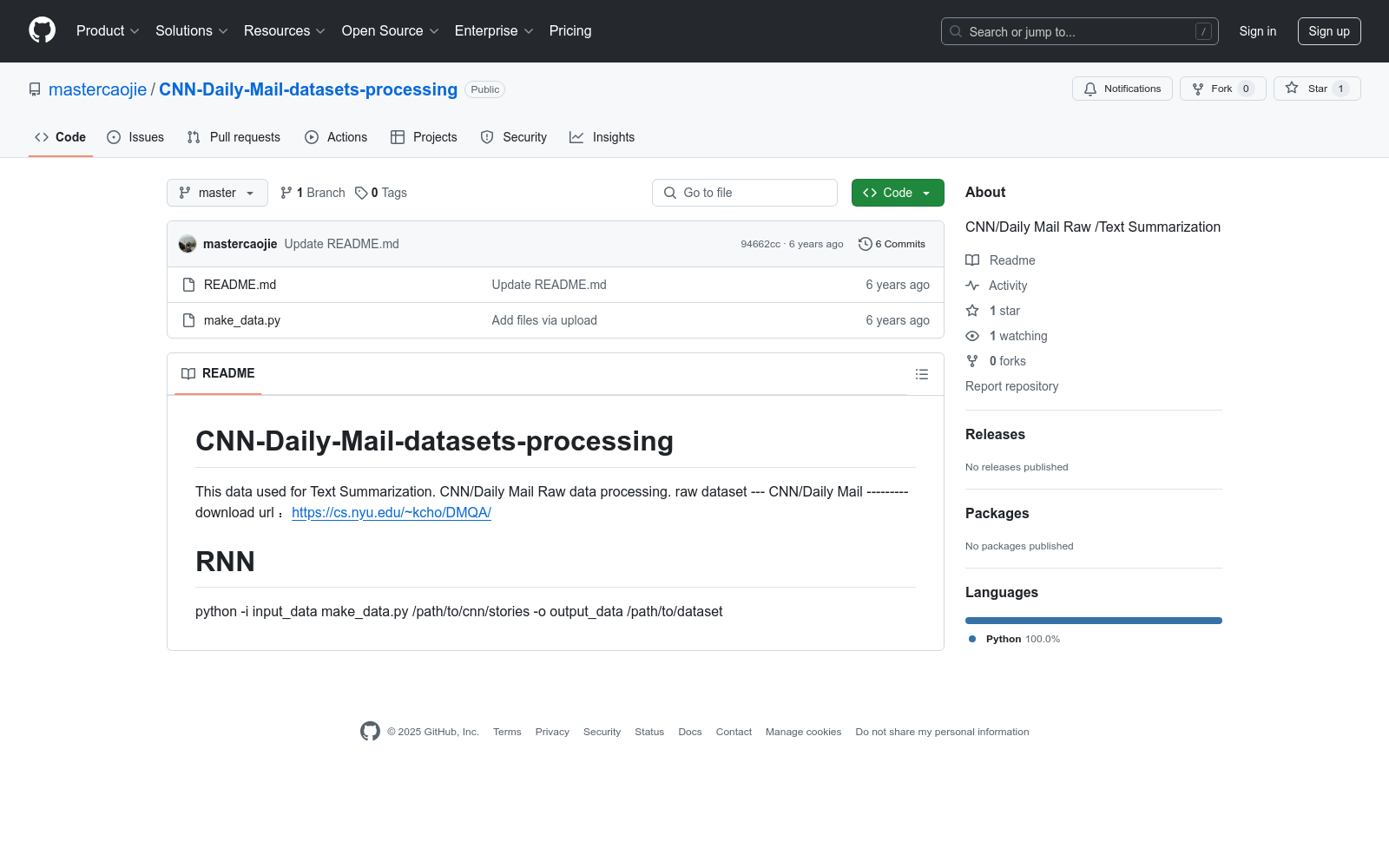

CNN/Daily Mail|新闻文本数据集|文本摘要数据集

收藏

ROBEL

ROBEL是一个开源的低成本机器人平台,专为现实世界的强化学习设计。该平台由谷歌研究院和加州大学伯克利分校共同开发,包含两个机器人:D'Claw,一个三指手机器人,用于促进精细操作任务的学习;D'Kitty,一个四足机器人,用于促进敏捷的腿式移动任务学习。这些模块化机器人易于维护且足够坚固,能够承受从零开始的硬件强化学习,目前已记录超过14000小时的训练时间。ROBEL提供了一系列连续控制基准任务,这些任务具有密集和稀疏的任务目标,并引入了硬件安全评分指标。数据集和相关材料可在www.roboticsbenchmarks.org访问,旨在解决强化学习在真实机器人上的应用问题,特别是在处理物理限制和环境交互方面的挑战。

arXiv 收录

PCLT20K

PCLT20K数据集是由湖南大学等机构创建的一个大规模PET-CT肺癌肿瘤分割数据集,包含来自605名患者的21,930对PET-CT图像,所有图像都带有高质量的像素级肿瘤区域标注。该数据集旨在促进医学图像分割研究,特别是在PET-CT图像中肺癌肿瘤的分割任务。

arXiv 收录

中国空气质量数据集(2014-2020年)

数据集中的空气质量数据类型包括PM2.5, PM10, SO2, NO2, O3, CO, AQI,包含了2014-2020年全国360个城市的逐日空气质量监测数据。监测数据来自中国环境监测总站的全国城市空气质量实时发布平台,每日更新。数据集的原始文件为CSV的文本记录,通过空间化处理生产出Shape格式的空间数据。数据集包括CSV格式和Shape格式两数数据格式。

国家地球系统科学数据中心 收录

中国省级灾害统计空间分布数据集(1999-2020年)

该数据集为中国省级灾害统计空间分布数据集,时间为1999-2020年。该数据集包含中国各省自然灾害、地质灾害、地震灾害、森林火灾、森林病虫鼠害、草原灾害六类灾害的详细数据。数据量为206MB,数据格式为excel。

国家地球系统科学数据中心 收录

中国陆域及周边逐日1km全天候地表温度数据集(TRIMS LST;2000-2023)

地表温度(Land surface temperature, LST)是地球表面与大气之间界面的重要参量之一。它既是地表与大气能量交互作用的直接体现,又对于地气过程具有复杂的反馈作用。因此,地表温度不仅是气候变化的敏感指示因子和掌握气候变化规律的重要前提,还是众多模型的直接输入参数,在许多领域有广泛的应用,如气象气候、环境生态、水文等。伴随地学及相关领域研究的深入和精细化,学术界对卫星遥感的全天候地表温度(All-weather LST)具有迫切的需求。 本数据集的制备方法是增强型的卫星热红外遥感-再分析数据集成方法。方法的主要输入数据为Terra/Aqua MODIS LST产品和GLDAS等数据,辅助数据包括卫星遥感提供的植被指数、地表反照率等。方法充分利用了卫星热红外遥感和再分析数据提供的地表温度高频分量、低频分量以及地表温度的空间相关性,最终重建得到较高质量的全天候地表温度数据集。 评价结果表明,本数据集具有良好的图像质量和精度,不仅在空间上无缝,还与当前学术界广泛采用的逐日1 km Terra/Aqua MODIS LST产品在幅值和空间分布上具有较高的一致性。当以MODIS LST为参考时,该数据集在白天和夜间的平均偏差(MBE)为0.09K和-0.03K,偏差标准差(STD)为1.45K和1.17K。基于19个站点实测数据的检验结果表明,其MBE为-2.26K至1.73K,RMSE为0.80K至3.68K,且在晴空与非晴空条件下无显著区别。 本数据集的时间分辨率为逐日4次,空间分辨率为1km,时间跨度为2000年-2023年;空间范围包括我国陆域的主要区域(包含港澳台地区,暂不包含我国南海诸岛)及周边区域(72°E-135°E,19°N-55°N)。本数据集的缩写名为TRIMS LST(Thermal and Reanalysis Integrating Moderate-resolution Spatial-seamless LST),以便用户使用。需要说明的是,TRIMS LST的空间子集TRIMS LST-TP(中国西部逐日1 km全天候地表温度数据集(TRIMS LST-TP;2000-2023)V2)同步在国家青藏高原科学数据中心发布,以减少相关用户数据下载和处理的工作量。

国家青藏高原科学数据中心 收录