FineTuneBench|大型语言模型数据集|微调评估数据集

收藏arXiv2024-11-11 更新2024-11-18 收录

下载链接:

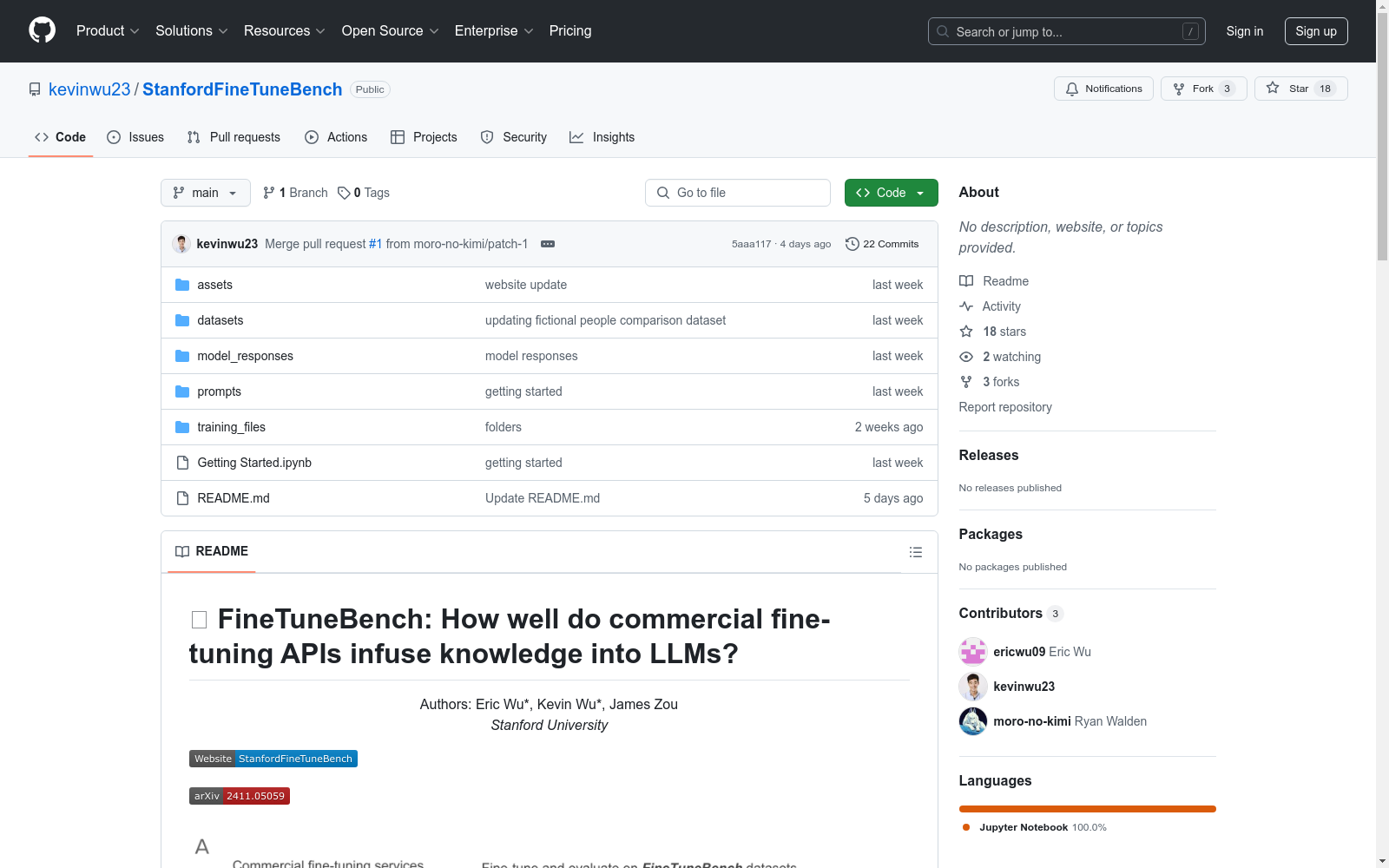

https://github.com/kevinwu23/StanfordFineTuneBench

下载链接

链接失效反馈资源简介:

FineTuneBench数据集由斯坦福大学创建,旨在评估商业化大型语言模型(LLMs)微调APIs在新知识注入和现有知识更新方面的效能。该数据集包含625个训练问题和1075个测试问题,覆盖新闻、虚构人物、医疗指南和代码更新四大领域。通过对比分析OpenAI和Google的五个前沿LLMs,包括GPT-4o和Gemini 1.5 Pro等,FineTuneBench揭示了微调服务在知识注入方面的显著不足。该数据集的创建过程基于最新新闻文章、虚构人物信息、医疗指南更新和代码框架变更,通过精心设计的问答对来测试模型的泛化能力。FineTuneBench的应用领域广泛,尤其适用于评估和改进LLMs在特定领域的知识更新和应用能力。

提供机构:

斯坦福大学

创建时间:

2024-11-11

AI搜集汇总

数据集介绍

构建方式

FineTuneBench数据集的构建基于对前沿大型语言模型(LLMs)在商业微调API下的知识注入能力的评估需求。该数据集包含四个领域的知识注入任务:最新新闻、虚构人物、医疗指南和代码更新。每个领域均包含训练问题和测试问题,旨在测试模型在摄取新信息和更新现有知识方面的有效性。数据集的生成过程包括从可靠来源收集最新信息,使用GPT-4o生成问题-答案对,并通过质量检查确保生成的内容符合标准。此外,数据集还包括对问题的重新表述和日期更改,以测试模型的泛化能力。

特点

FineTuneBench数据集的特点在于其多领域覆盖和严格的生成流程。数据集不仅涵盖了新闻、虚构人物、医疗和代码四个领域,还通过重新表述和日期更改等方式,增加了问题的复杂性和多样性,从而更全面地评估模型的知识注入能力。此外,数据集的生成过程严格遵循科学方法,确保每个问题和答案对的质量和可靠性。

使用方法

FineTuneBench数据集适用于评估和比较不同商业微调API在知识注入任务中的表现。用户可以通过该数据集对模型进行微调,并测试其在原始问题、重新表述问题和日期更改问题上的表现,以评估模型的记忆和泛化能力。数据集还提供了详细的训练和评估指南,帮助用户在不同领域和任务中进行系统的模型评估和优化。

背景与挑战

背景概述

随着大型语言模型(LLMs)在软件开发和医学等多样化领域的应用日益增多,确保这些模型包含最新和相关的知识变得至关重要。例如,软件开发者需要模型理解最新版本的代码,而医疗专业人员则需要可信赖的模型遵循当前的临床指南。此外,企业希望将这些模型适应内部使用,需要引入全新的知识,如员工信息或最新新闻。然而,目前大多数前沿模型是闭源的,用户无法直接应用模型微调技术。最近,一些公司通过商业API提供了对专有模型的监督微调,如OpenAI的微调UI和Google Vertex AI。这些服务为用户提供了一种适应闭源且计算成本高昂的前沿模型的途径。然而,这些微调服务是否能够实现知识注入,即学习新知识和更新知识的能力,尚不清楚。

当前挑战

FineTuneBench数据集旨在评估商业微调API在注入新知识和更新现有知识方面的有效性。主要挑战包括:1) 商业API提供的微调方法细节不明确,如Google Vertex AI允许用户指定‘适配器大小’,而OpenAI未提供任何细节;2) 缺乏统一的基准来评估这些方法并进行比较;3) 用户在超参数优化方面受到限制,默认值的建议可能不足以使模型适应新知识和更新知识。此外,模型在记忆原始问题后,在回答重新表述的问题或日期改变的问题时表现不佳,表明存在过度拟合问题。总体而言,当前商业微调服务在实现可靠知识注入方面存在显著不足。

常用场景

经典使用场景

FineTuneBench数据集的经典使用场景主要集中在评估商业微调API在向大型语言模型(LLMs)注入新知识和更新现有知识方面的有效性。通过分析包括GPT-4o和Gemini 1.5 Pro在内的五个前沿LLMs,该数据集在两个关键设置中测试了这些模型的能力:一是吸收新信息,如最近的新闻事件和新的人物简介;二是更新现有知识,如更新的医疗指南和代码框架。

解决学术问题

FineTuneBench数据集解决了当前学术界在理解商业微调API如何有效注入新知识和更新现有知识方面的关键问题。通过提供一个系统化的评估框架和数据集,该研究揭示了现有模型在通过微调学习新信息方面的显著不足,平均泛化准确率仅为37%。在更新现有知识方面,如整合医疗指南更新,商业微调API的能力更为有限,平均泛化准确率仅为19%。这些发现强调了当前商业微调服务在实现可靠知识注入方面的主要缺陷。

衍生相关工作

FineTuneBench数据集的引入激发了一系列相关研究工作,特别是在知识注入和模型微调领域。例如,一些研究探索了通过多适配器模型将知识注入BERT的方法,以及比较了继续预训练与检索增强生成(RAG)在模型如Llama-2-7B和Mistral-7B中的有效性。此外,Chen等人的研究探讨了在浅层选择性微调Llama-2-7B以实现知识注入。这些工作都是在FineTuneBench数据集的基础上进行的,进一步推动了LLMs在知识注入和更新方面的研究。

以上内容由AI搜集并总结生成