IVLLab/MultiDialog|多模态对话数据集|情感分析数据集

收藏数据集描述

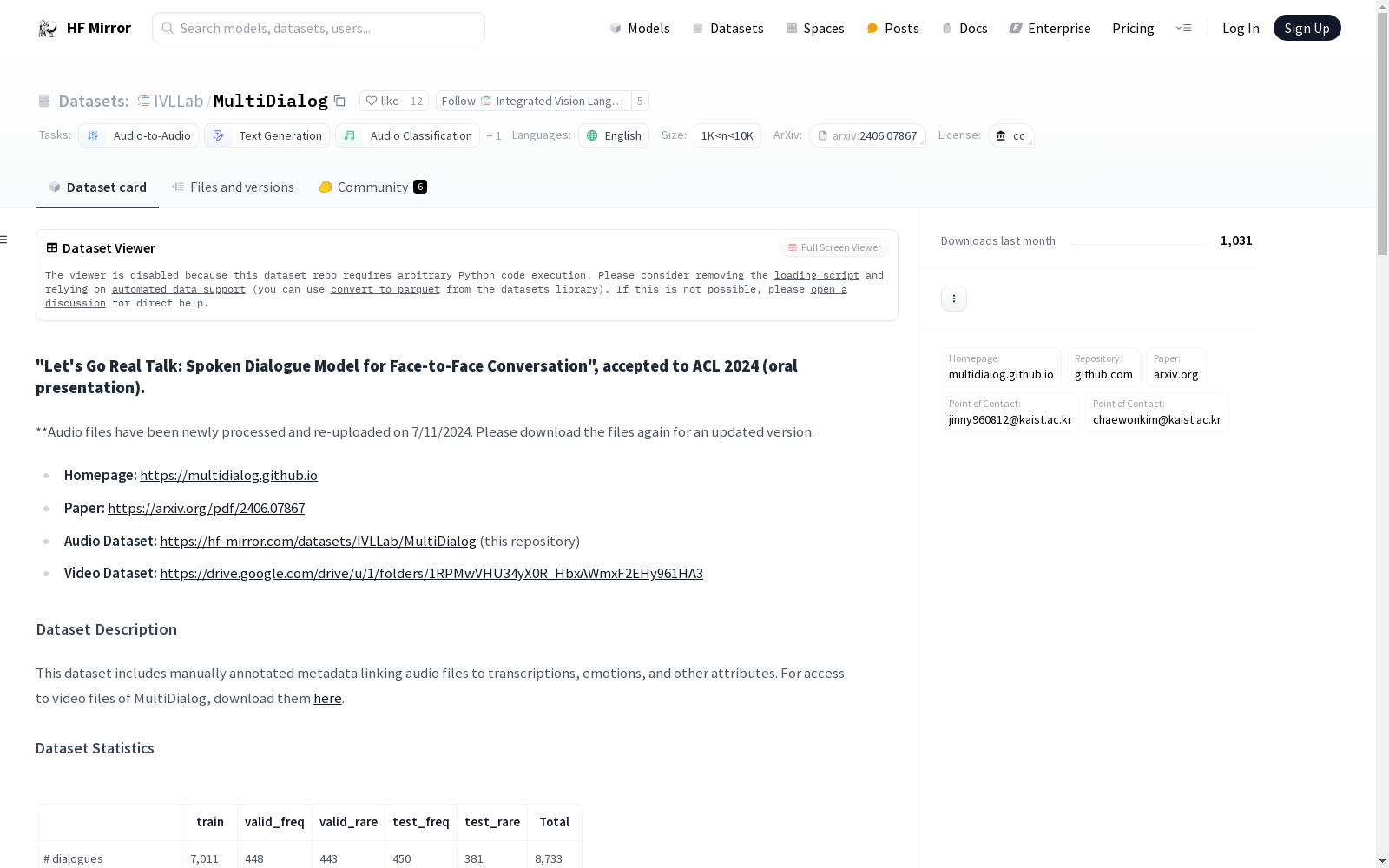

该数据集包含手动标注的元数据,将音频文件与转录、情感和其他属性关联起来。对于MultiDialog的视频文件访问,请在此处下载。

数据集统计

| train | valid_freq | valid_rare | test_freq | test_rare | Total | |

|---|---|---|---|---|---|---|

| # 对话数 | 7,011 | 448 | 443 | 450 | 381 | 8,733 |

| # 话语数 | 151,645 | 8,516 | 9,556 | 9,811 | 8,331 | 187,859 |

| 平均每对话话语数 | 21.63 | 19.01 | 21.57 | 21.80 | 21.87 | 21.51 |

| 平均每话语长度(秒) | 6.50 | 6.23 | 6.40 | 6.99 | 6.49 | 6.51 |

| 平均每对话长度(分钟) | 2.34 | 1.97 | 2.28 | 2.54 | 2.36 | 2.33 |

| 总长度(小时) | 273.93 | 14.74 | 17.00 | 19.04 | 15.01 | 339.71 |

示例用法

数据集包含train, test_freq, test_rare, valid_freq, 和 valid_rare 几个部分。以下是一个示例用法:

python from datasets import load_dataset

MultiD = load_dataset("IVLLab/MultiDialog", "valid_freq", use_auth_token=True)

查看结构

print(MultiD)

动态加载音频样本

audio_input = MultiD["valid_freq"][0]["audio"] # 第一个解码的音频样本 transcription = MultiD["valid_freq"][0]["value"] # 第一个转录

支持的任务

多模态对话生成:该数据集可用于训练端到端的多模态对话生成模型。自动语音识别:该数据集可用于训练自动语音识别(ASR)模型。文本到语音:该数据集也可用于训练文本到语音(TTS)模型。

语言

Multidialog包含英语的音频和转录数据。

黄金情感对话子集

我们提供了一个黄金情感对话子集,这是一个更可靠的资源,用于研究对话中的情感动态。我们将情感准确率高于40%的演员的对话分类为黄金情感对话。请使用以下id的演员的对话:a, b, c, e, f, g, i, j, 和 k。

数据集结构

数据实例

python { file_name: t_ffa55df6-114d-4b36-87a1-7af6b8b63d9b/t_ffa55df6-114d-4b36-87a1-7af6b8b63d9b_0k.wav conv_id: t_ffa55df6-114d-4b36-87a1-7af6b8b63d9b, utterance_id: 0, from: gpt, audio: { path: /home/user/.cache/huggingface/datasets/downloads/extracted/cache_id/t_152ee99a-fec0-4d37-87a8-b1510a9dc7e5/t_152ee99a-fec0-4d37-87a8-b1510a9dc7e5_0i.wav, array: array([0.0005188 , 0.00085449, 0.00012207, ..., 0.00125122, 0.00076294, 0.00036621], dtype=float32), sampling_rate: 16000 }, value: Are you a football fan?, emotion: Neutral, original_full_path: valid_freq/t_ffa55df6-114d-4b36-87a1-7af6b8b63d9b/t_ffa55df6-114d-4b36-87a1-7af6b8b63d9b_0k.wav }

数据字段

file_name(字符串) - 特定分割目录中音频样本的相对文件路径。conv_id(字符串) - 每个对话的唯一标识符。utterance_id(浮点数) - 话语索引。from(字符串) - 消息的来源(人类,gpt)。audio(音频特征) - 包含音频路径、解码的音频数组和采样率的字典。- 在非流模式(默认)中,路径指向本地提取的音频。在流模式中,路径是存档内音频段的相对路径(文件未下载并本地提取)。

value(字符串) - 话语的转录。emotion(字符串) - 话语的情感。original_full_path(字符串) - 原始数据目录中原始完整音频样本的相对路径。

情感标签包括:"Neutral", "Happy", "Fear", "Angry", "Disgusting", "Surprising", "Sad"

中国区域交通网络数据集

该数据集包含中国各区域的交通网络信息,包括道路、铁路、航空和水路等多种交通方式的网络结构和连接关系。数据集详细记录了各交通节点的位置、交通线路的类型、长度、容量以及相关的交通流量信息。

data.stats.gov.cn 收录

学生课堂行为数据集 (SCB-dataset3)

学生课堂行为数据集(SCB-dataset3)由成都东软学院创建,包含5686张图像和45578个标签,重点关注六种行为:举手、阅读、写作、使用手机、低头和趴桌。数据集覆盖从幼儿园到大学的不同场景,通过YOLOv5、YOLOv7和YOLOv8算法评估,平均精度达到80.3%。该数据集旨在为学生行为检测研究提供坚实基础,解决教育领域中学生行为数据集的缺乏问题。

arXiv 收录

AISHELL/AISHELL-1

Aishell是一个开源的中文普通话语音语料库,由北京壳壳科技有限公司发布。数据集包含了来自中国不同口音地区的400人的录音,录音在安静的室内环境中使用高保真麦克风进行,并下采样至16kHz。通过专业的语音标注和严格的质量检查,手动转录的准确率超过95%。该数据集免费供学术使用,旨在为语音识别领域的新研究人员提供适量的数据。

hugging_face 收录

用于陆面模拟的中国土壤数据集(第二版)

本研究对中国范围内0-2米六个标准深度层(0-5、5-15、15-30、30-60、60-100和100-200厘米)的23种土壤物理和化学属性进行了90米空间分辨率的制图。该数据集源自第二次土壤普查的8979个土壤剖面,世界土壤信息服务的1540个土壤剖面,第一次全国土壤普查的76个土壤剖面,以及区域数据库的614个土壤剖面。该数据集包括pH值、砂粒、粉粒、粘粒、容重、有机碳含量、砾石、碱解氮、总氮、阳离子交换量、孔隙度、总钾、总磷、有效钾、有效磷和土壤颜色(包括蒙赛尔颜色和RGB两种形式)。数据集的缺失值为“fillvalue = -32768”。数据集以栅格格式提供,有Tiff和netCDF两种格式。为了满足陆面建模中不同应用对空间分辨率的不同要求,CSDLv2 提供了 90 米、1 公里和 10公里空间分辨率的版本。各个土壤属性的单位参见说明文档。该数据集相对于第一版具有更好的数据质量,可广泛应用于陆面过程模拟等地学相关研究。

国家青藏高原科学数据中心 收录

URPC系列数据集, S-URPC2019, UDD

URPC系列数据集包括URPC2017至URPC2020DL,主要用于水下目标的检测和分类。S-URPC2019专注于水下环境的特定检测任务。UDD数据集信息未在README中详细描述。

github 收录